Meta a annoncé, mardi 29 avril 2025 dans un communiqué, le lancement d’une application autonome Meta AI, intégrant son modèle de nouvelle génération Llama 4, et conçue pour offrir une expérience conversationnelle vocale plus fluide, plus personnalisée et multiplateforme. Cette app marque un tournant stratégique vers une intelligence artificielle omniprésente et intégrée à l’écosystème Meta.

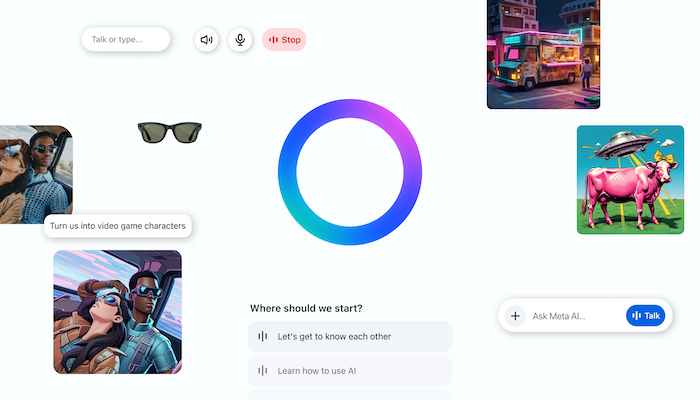

Déployée dans un premier temps aux États-Unis, au Canada, en Australie et en Nouvelle-Zélande, l’application propose une interaction vocale bidirectionnelle en temps réel grâce à une technologie de synthèse vocale full-duplex. Contrairement aux assistants classiques, Meta AI ne se contente plus de lire des réponses textuelles : elle génère directement une voix naturelle, modélisée sur des dialogues humains. Cette démo vocale, bien qu’encore limitée (pas de connexion en temps réel au web), vise à préfigurer les futures interfaces IA orientées audio.

Construite sur Llama 4, Meta AI tire parti des données contextuelles issues des produits Meta (Facebook, Instagram, Messenger) pour générer des réponses plus pertinentes. Les utilisateurs peuvent indiquer manuellement certaines préférences (centres d’intérêt, habitudes de voyage, etc.) ou laisser l’IA les déduire du contexte. Lorsque les comptes Facebook et Instagram sont reliés via le Centre de Comptes, l’IA dispose d’un socle enrichi pour proposer une expérience hautement personnalisée.

La composante visuelle n’est pas en reste : génération et édition d’images sont accessibles via commande vocale ou écrite. L’app intègre également un fil “Découverte”, permettant aux utilisateurs de consulter ou partager des prompts d’IA populaires, remixables à volonté. Aucun contenu n’est partagé publiquement sans action explicite de l’utilisateur, soulignant un positionnement orienté privacy by default.

L’application a, par ailleurs, été conçue pour fonctionner en synergie avec tous les supports Meta. L’une des nouveautés majeures est l’intégration native avec les lunettes Ray-Ban Meta, véritable vitrine hardware de l’IA embarquée. Une conversation lancée sur les lunettes peut être poursuivie depuis l’application ou l’interface web. Les utilisateurs peuvent accéder à l’historique des échanges, mais l’inverse (reprise depuis les lunettes d’une conversation débutée sur le web ou l’app) n’est pas encore possible.

La version web de Meta AI bénéficie également d’une refonte. L’interface a été optimisée pour les workflows sur écran large, avec notamment une expérience de génération d’images enrichie (préréglages de style, ambiance, éclairage) et l’introduction d’un éditeur de documents assisté par IA. Elle permet de générer des documents multimédia exportables en PDF, voire d’analyser des fichiers importés – une fonctionnalité actuellement en phase de test dans certains pays.

N.J d’après communiqué